เทคโนโลยีเกิดใหม่ต่าง ๆ สู่การนำมาประยุกต์ใช้เพื่อปฏิรูปองค์กรอย่างเต็มรูปแบบ ผู้นำในปัจจุบันไม่ได้หยุดอยู่เพียงขั้นการทดลอง แต่กำลังมุ่งเน้นว่าจะนำเทคโนโลยีมาใช้งานจริงอย่างมีประสิทธิภาพและรับผิดชอบได้อย่างไร เพื่อให้เกิดผลตอบแทนที่วัดผลได้ในระดับโครงสร้าง พร้อมทั้งผนวก AI เข้าเป็นแกนหลักของแพลตฟอร์มดิจิทัล

ยุคของ AI กำลังเปลี่ยนผ่านสู่ความชำนาญเฉพาะด้าน องค์กรต่างต้องการระบบที่ได้รับการปรับแต่งให้เข้ากับบริบทของอุตสาหกรรม ข้อมูล และรูปแบบการดำเนินงานจริงของตนเอง ที่มาพร้อมอิสระในการรันเวิร์กโหลดเหล่านี้ได้ทุกที่บนสภาพแวดล้อมที่เหมาะสมที่สุด ไม่ว่าจะเป็นภายในศูนย์ข้อมูลของตนเอง (on-premise), บนคลาวด์ หรือที่ edge เร้ดแฮทเชื่อว่าการผสานรวมระหว่างความชาญฉลาดที่เฉพาะเจาะจง และ ความยืดหยุ่นในการเลือกใช้สถาปัตยกรรม คือเทรนด์สำคัญที่จะกำหนดทิศทางเทคโนโลยีในปี 2026

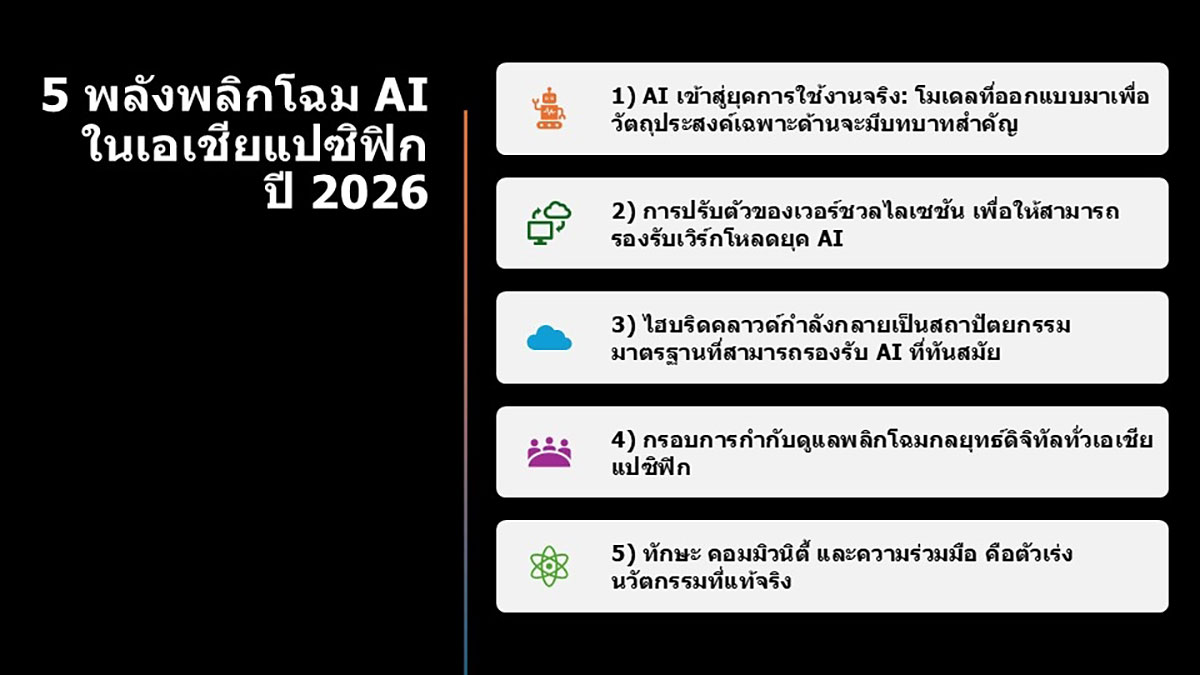

- AI เข้าสู่ยุคการใช้งานจริง: โมเดลที่ออกแบบมาเพื่อวัตถุประสงค์เฉพาะด้านจะมีบทบาทสำคัญ

หากช่วงปี 2023 ถึง 2025 คือยุคแห่งความตื่นเต้นในศักยภาพของ generative AI ปี 2026 ก็จะเป็นปีที่มุ่งเน้นผลลัพธ์จากการใช้งานจริง เราได้ข้ามผ่านขั้นตอนการพิสูจน์ว่า AI มีศักยภาพอะไรบ้างในช่วงสองปีที่ผ่านมา มาสู่การพิสูจน์ให้เห็นคุณค่าของ AI ที่สามารถตอบโจทย์ความต้องการเฉพาะด้านของธุรกิจ

ผลการศึกษาล่าสุดจาก IDC พบว่า 70% ขององค์กรในเอเชียแปซิฟิก คาดการณ์ว่า agentic AI จะเข้ามาพลิกโฉมโมเดลธุรกิจของตนภายใน 18 เดือนข้างหน้า1 องค์กรธุรกิจเริ่มตระหนักว่าอนาคตของ AI ไม่ใช่การใช้โมเดลเดียวที่ทำได้ครอบจักรวาล แต่คือระบบ AI ที่มีความเฉพาะทาง มีขนาดพอเหมาะกับงาน สามารถอธิบายที่มาที่ไปได้ และออกแบบมาอย่างเฉพาะเจาะจงสำหรับอุตสาหกรรมและเวิร์กโฟลว์ต่าง ๆ ที่แตกต่างกัน การเปลี่ยนแปลงนี้สอดคล้องกับอีกหนึ่งการคาดการณ์ของ IDC ที่ว่า ภายในปี 2027 องค์กร 40% จะหันไปใช้ชิปสั่งทำพิเศษที่มีประสิทธิภาพเฉพาะทาง (custom silicon) เช่น หน่วยประมวลผล ARM หรือชิปเฉพาะทางสำหรับ AI/ML เพื่อตอบสนองการเพิ่มขึ้นของความต้องการด้านการเพิ่มประสิทธิภาพการทำงานสูงสุด ความคุ้มค่าด้านต้นทุน และการประมวลผลเฉพาะด้าน2

โดยเฉพาะอย่างยิ่งในภาคการเงิน การใช้ AI ที่ออกแบบมาเพื่อวัตถุประสงค์เฉพาะด้าน (fit-for-purpose AI) สามารถเปลี่ยนกระบวนการที่ซับซ้อนและมีปริมาณมหาศาลให้เป็นอัตโนมัติ เช่น ขั้นตอนการรับลูกค้าใหม่ (client onboarding) การตรวจสอบรายการธุรกรรม และการวิเคราะห์การทุจริต ซึ่งงานเหล่านี้ยังคงต้องใช้บุคลากรทำด้วยตัวเองเป็นส่วนใหญ่ ระบบ AI เฉพาะทางเหล่านี้จะช่วยปูทางไปสู่การเพิ่มความแม่นยำ ลดต้นทุน และยกระดับการบริหารจัดการความเสี่ยงให้แข็งแกร่งกว่าเดิม ให้กับสถาบันการเงินที่ต้องเผชิญกับแรงกดดันด้านกฎระเบียบและการปฏิบัติงานที่เพิ่มสูงขึ้น

ซึ่งสอดคล้องกับแผนปฏิบัติการด้านปัญญาประดิษฐ์แห่งชาติเพื่อการพัฒนาประเทศไทย (พ.ศ. 2565-2570) ระยะที่สอง (พ.ศ. 2567-2570) ที่รัฐบาลได้จัดให้ภาคการเงินเป็นหนึ่งในเจ็ดอุตสาหกรรมเป้าหมายที่ต้องเร่งนำ AI มาใช้ เพื่อเพิ่มศักยภาพทางเศรษฐกิจ ธนาคารพาณิชย์ในไทยเริ่มใช้ AI ในการวิเคราะห์ข้อมูลเพื่อการปล่อยสินเชื่อ สำหรับกลุ่มลูกค้ารายย่อยและกลุ่มที่ไม่มีรายได้ประจำ ซึ่งช่วยให้การเข้าถึงบริการทางการเงินกว้างขวางขึ้น นอกจากนี้นโยบาย Cloud First Policy ของภาครัฐและเกณฑ์การกำกับดูแลของธนาคารแห่งประเทศไทย (ธปท.) กำลังผลักดันให้องค์กรหันมาใช้ cloud-native services และ containerization เพื่อเพิ่มความยืดหยุ่นในการจัดการข้อมูลและรองรับการประมวลผล AI อย่างมีประสิทธิภาพ

ผู้นำธุรกิจจึงจำเป็นต้องทบทวนกลยุทธ์ด้านโครงสร้างพื้นฐาน เพื่อให้สามารถรองรับเวิร์กโหลด AI ที่มีความหลากหลายและซับซ้อนมากขึ้น เราจะเห็นความต้องการที่เพิ่มสูงขึ้นในเรื่องของเลเยอร์การอนุมาน AI แบบรวมศูนย์ต่าง ๆ (unified inference layers) ที่สามารถรองรับโมเดล AI ได้หลากหลาย โดยไม่ส่งผลกระทบต่อประสิทธิภาพและความคุ้มค่าด้านต้นทุน ในเวลาเดียวกันนี้ เราจะได้เห็นแรงขับเคลื่อนที่สำคัญในการเชื่อมโยงแพลตฟอร์มแอปพลิเคชันขององค์กรเข้ากับเทคโนโลยีเร่งความเร็ว AI บนคลาวด์ (cloud-based AI accelerators) ซึ่งช่วยให้องค์กรสามารถนำ AI มาใช้งานจริงในวงกว้างได้อย่างราบรื่น การจับคู่ระหว่างแพลตฟอร์มที่มีความยืดหยุ่นเข้ากับการประมวลผลเฉพาะทางจะช่วยให้องค์กรเปลี่ยนผ่านจากการทดลองใช้ AI ไปสู่การใช้งานจริงที่สร้างผลลัพธ์ทางธุรกิจที่วัดผลได้ ได้รวดเร็วยิ่งขึ้น

- การปรับตัวของเวอร์ชวลไลเซชัน เพื่อให้สามารถรองรับเวิร์กโหลดยุค AI

AI กำลังเข้ามาปรับเปลี่ยนแนวคิดเรื่องโครงสร้างพื้นฐานขององค์กรไปอย่างสิ้นเชิง แนวทางการใช้เวอร์ชวลไลเซชันแบบเดิมที่สร้างมาเพื่อรองรับเวิร์กโหลดที่คาดการณ์ได้และมีรูปแบบตายตัว กำลังถูกท้าทายด้วยความต้องการของ AI ที่ทันสมัย ซึ่งจำเป็นต้องใช้ประสิทธิภาพที่สูงขึ้น มีระยะเวลาตอบสนองของระบบ (latency) ที่ต่ำลง และต้องการความยืดหยุ่นที่มากกว่าเดิมอย่างมหาศาล

ในปี 2026 องค์กรจะหันมาใช้กลยุทธ์เวอร์ชวลไลเซชันที่รวมเอาทั้งเวอร์ชวลแมชชีน คอนเทนเนอร์ และการประมวลผลเฉพาะทางเข้ามาอยู่ภายใต้โมเดลการทำงานเดียวกันมากขึ้น ซึ่งจะช่วยทีมงานที่ดูแลแพลตฟอร์มสามารถปรับปรุงระบบให้ทันสมัยได้ตามความต้องการของตน ในขณะที่ยังสามารถรองรับได้ทั้งแอปพลิเคชันเดิมและเวิร์กโหลด AI ใหม่ ๆ ผลลัพธ์ที่ได้คือโครงสร้างพื้นฐานที่มีความยืดหยุ่นเพียงพอที่จะใช้งานแอปพลิเคชันแบบดั้งเดิมและระบบอัจฉริยะควบคู่กันไปได้ โดยไม่ลดทอนการกำกับดูแลหรือการควบคุม

- ไฮบริดคลาวด์กำลังกลายเป็นสถาปัตยกรรมมาตรฐานที่สามารถรองรับ AI ที่ทันสมัย

การที่โมเดล AI ต้องพึ่งพาข้อมูลแบบเรียลไทม์ ระบบประมวลผลแบบกระจายตัว และทรัพยากรการประมวลผลเฉพาะทางมากขึ้นเรื่อย ๆ ทำให้องค์กรจำเป็นต้องใช้สถาปัตยกรรมที่ช่วยให้สามารถรันเวิร์กโหลดได้ใกล้กับแหล่งที่มาของข้อมูลของตนให้ได้มากที่สุดเท่าที่จะเป็นไปได้ ในขณะที่ยังคงความสามารถในการขยายขนาดการทำงาน และความสามารถในการฟื้นฟูระบบได้อย่างแข็งแกร่ง และดำเนินธุรกิจได้อย่างต่อเนื่อง

ความต้องการที่ซับซ้อนของ AI จำเป็นต้องใช้ไฮบริดคลาวด์ ในปี 2026 ไฮบริดคลาวด์จะตอกย้ำสถานะการเป็นโมเดลมาตรฐานให้กับระบบอัจฉริยะต่าง ๆ ขององค์กร องค์กรต่างๆ จะให้ความสำคัญกับแพลตฟอร์มที่ช่วยให้พวกเขายังคงสิทธิ์ในการควบคุมเวิร์กโหลดที่อ่อนไหวภายไว้ภายในองค์กรของตน (on-premises) ในขณะเดียวกันก็สามารถขยายขีดความสามารถได้อย่างรวดเร็วผ่านพับลิคคลาวด์ และสามารถส่งต่อความฉลาดของระบบไปใกล้จุดกำเนิดของข้อมูลที่ edge ได้อย่างมีประสิทธิภาพ

ไฮบริดคลาวด์คือคำตอบที่ลงตัวที่สุดสำหรับองค์กรในภาคการเงิน เนื่องจากเวิร์กโหลดที่ต้องอยู่ภายใต้การกำกับดูแลและมีความอ่อนไหวสูงจำเป็นต้องได้รับการจัดเก็บไว้ภายในองค์กร ในขณะที่การวิเคราะห์ข้อมูลด้วย AI มักต้องการความยืดหยุ่นและพลังประมวลผลเฉพาะทางบนพับลิคคลาวด์ การรักษาสมดุลนี้กำลังกลายเป็นพื้นฐานที่สถาบันการเงินต้องมี เพื่อยกระดับระบบบริหารจัดการความเสี่ยง การปฏิบัติตามกฎระเบียบ และปรับปรุงระบบดูแลลูกค้าให้ทันสมัยยิ่งขึ้น

เรื่องนี้สะท้อนถึงความจริงที่สำคัญของอุตสาหกรรมว่า AI จะไม่ได้ถูกจำกัดให้รันอยู่แค่ที่ใดที่หนึ่ง ดังนั้น องค์กรที่สามารถออกแบบสภาพแวดล้อมให้รองรับการรัน AI ได้จากทุกสภาพแวดล้อม คือ ผู้ที่อยู่ในจุดที่ได้เปรียบที่สุดในการคว้าโอกาสและสร้างมูลค่าจาก AI ได้อย่างเต็มประสิทธิภาพ

- กรอบการกำกับดูแลพลิกโฉมกลยุทธ์ดิจิทัลทั่วเอเชียแปซิฟิก

เมื่อมีการนำ AI มาใช้เพิ่มขึ้นอย่างรวดเร็ว การกำกับดูแลกลายเป็นหนึ่งในแรงขับเคลื่อนสำคัญที่สุดในการกำหนดทิศทางกลยุทธ์ดิจิทัลในภูมิภาคเอเชียแปซิฟิก กรอบการกำกับดูแลที่แข็งแกร่งมากขึ้นจะมีอิทธิพลต่อรูปแบบการนำ AI มาใช้ ทั้งนี้ องค์กรต่างต้องการระบบที่มีความปลอดภัยสูง โปร่งใส และสอดคล้องกับกฎระเบียบในท้องถิ่น อีกทั้งยังคาดหวังเพิ่มขึ้นว่าแพลตฟอร์มเทคโนโลยีที่ตนเลือกใช้จะสามารถรองรับข้อกำหนดเหล่านี้ได้ ทั้งในสภาพแวดล้อมแบบไฮบริดคลาวด์และมัลติคลาวด์

ภูมิภาคเอเชียตะวันออกเฉียงใต้กำลังสร้างกรอบการกำกับดูแลที่สร้างสมดุลระหว่างนวัตกรรมและการปฏิบัติตามกฎระเบียบ หน่วยงานภาครัฐของไทยให้ความสำคัญในการส่งเสริมให้ทุกภาคส่วนเกิดการประยุกต์ใช้ AI อย่างมีจริยธรรม เหมาะสม ลดความเสี่ยงที่อาจจะเกิดขึ้น โดยสำนักงานพัฒนาธุรกรรมทางอิเล็กทรอนิกส์ (ETDA) ผ่านศูนย์ AI Governance Center (AIGC) ได้จัดทำแนวทางปฏิบัติสำหรับการใช้ AI อย่างมีธรรมาภิบาล เพื่อเป็นมาตรฐานให้ภาคเอกชนและกลุ่มการเงินนำไปปรับใช้ให้สอดคล้องกับกฎหมายท้องถิ่น เช่น PDPA หรือแม้แต่แนวทางสากลต่าง ๆ ทั้งในแง่เทคนิค กฎหมาย และการนำไปใช้งานจริง

บริการทางการเงินต่าง ๆ จะมีบทบาทสำคัญมากในการกำหนดมาตรฐานเหล่านี้ ข้อกำหนดที่เข้มงวดในด้านที่ต้องสามารถตรวจสอบได้ (auditability) สามารถติดตามย้อนกลับได้ (traceability) และพฤติกรรมของโมเดล ทำให้องค์กรในธุรกิจการเงินกลายเป็นผู้กำหนดบรรทัดฐานของการนำ AI มาใช้อย่างมีความรับผิดชอบ ซึ่งเป็นการสร้างต้นแบบที่องค์กรในอุตสาหกรรมอื่น ๆ มีแนวโน้มที่จะปฏิบัติตาม

กฎระเบียบหรือข้อกำหนดเหล่านี้ไม่ได้ทำให้การสร้างสรรค์นวัตกรรมล่าช้าลง แต่กลับเป็นตัวช่วยส่งเสริมนวัตกรรม ในปี 2026 องค์กรจะให้ความสำคัญมากขึ้นกับระบบ AI ที่สามารถตรวจสอบ ติดตาม และกำกับดูแลได้บนสภาพแวดล้อมไฮบริด เพื่อให้มั่นใจว่าการตัดสินใจทุกครั้งจะสามารถตรวจสอบย้อนกลับได้ และโมเดลทำงานได้อย่างถูกต้องตามที่คาดหวัง การเปลี่ยนแปลงด้านการกำกับดูแลนี้จะส่งผลต่อการตัดสินใจเลือกสถาปัตยกรรมทางเทคโนโลยีและผู้ให้บริการ รวมถึงลำดับความสำคัญด้านทักษะ องค์กรจะมองหาโซลูชันที่เป็นระบบเปิดและน่าเชื่อถือที่องค์กรสามารถตรวจสอบวิธีการสร้างโมเดล การใช้ข้อมูล และที่มาของการตัดสินใจได้ ความสามารถเหล่านี้จะกลายเป็นข้อกำหนดพื้นฐานที่ขาดไม่ได้สำหรับอุตสาหกรรมที่มีกฎระเบียบเข้มงวด เช่น บริการทางการเงิน

5) ทักษะ คอมมิวนิตี้ และความร่วมมือ คือตัวเร่งนวัตกรรมที่แท้จริง

ไม่มีการเปลี่ยนแปลงใดเกิดขึ้นได้หากปราศจากคน ความต้องการบุคลากรที่มีทักษะด้าน cloud-native, AI และความปลอดภัยทางไซเบอร์ ยังคงมีมากกว่าจำนวนบุคลากรที่มีอยู่ในตลาดทั่วภูมิภาคเอเชียแปซิฟิก และในปี 2026 ช่องว่างนี้จะยิ่งขยายกว้างขึ้น เว้นแต่ว่าองค์กรจะเริ่มลงทุนในแนวทางที่เน้นทักษะเป็นหลัก (skills-first approach) เพื่อสร้าง ดำเนินงาน และเพิ่มประสิทธิภาพระบบดิจิทัลที่ทันสมัย

ประเทศไทยมุ่งเน้นการสร้างคนผ่านโครงการ AI Reskill/Upskill โดยตั้งเป้าพัฒนาบุคลากรด้าน AI ให้ได้อย่างน้อย 30,000 คน ภายในปี 2570 เพื่อลดช่องว่างการขาดแคลนทักษะดิจิทัล มีความร่วมมือระหว่างภาครัฐ (DE และ MHESI) และเอกชนในการสร้าง GDCC AI Marketplace เพื่อเป็นศูนย์กลางเครื่องมือและบริการ AI ที่คนไทยเข้าถึงได้ง่าย โดยได้เปิดตัวแอปพลิเคชันต่าง ๆ เช่น AI platform, security platform, data analytic platform เป็นต้น

ชุมชนโอเพ่นซอร์ส หรือ โอเพ่นซอร์สคอมมิวนิตี้ จะเป็นหัวใจสำคัญของการเปลี่ยนแปลงนี้ ชุมชนโอเพ่นซอร์สต่าง ๆ เป็นแหล่งรวมการแบ่งปันความรู้ ความโปร่งใส และเป็นระบบนิเวศระดับโลกที่หยั่งรากอยู่บนการทำงานร่วมกันอย่างแท้จริง เครื่องมือและกรอบการทำงานต่าง ๆ เปิดกว้างให้ทุกคนสามารถเข้าถึงได้ แทนที่จะจำกัดอยู่เพียงคนบางกลุ่ม และเมื่อองค์กรต่าง ๆ เข้ามามีส่วนร่วมในการแบ่งปันไอเดียกลับสู่คอมมิวนิตี้เหล่านี้ รวมถึงการต่อยอดไอเดียเหล่านี้อย่างรวดเร็วและมีความรับผิดชอบ จะส่งให้ภูมิภาคเอเชียแปซิฟิกมีความแข็งแกร่งยิ่งขึ้นในด้านนวัตกรรมดิจิทัล และไม่ได้เป็นเพียงผู้ใช้เทคโนโลยีอีกต่อไป แต่จะก้าวสู่การเป็นผู้สร้างนวัตกรรมทางเทคโนโลยี

ประเทศไทยเองก็ได้มีการพัฒนา AI สัญชาติไทยกว่ายี่สิบรายการ ทั้งด้านการให้บริการ AI ครบวงจร, แพลตฟอร์ม บริการ AI และระบบสื่อสารหุ่นยนต์ภาษาไทย, แพลตฟอร์มด้านพลังงานที่ใช้, บริการ DevOps as a Service และ Linux System Admin, และแอปพลิเคชัน AI เฉพาะทางสำหรับการเกษตรและการวินิจฉัยภาพทางการแพทย์ที่แม่นยำ เป็นต้น

อนาคตของ AI องค์กรในยุคหน้า จะถูกกำหนดโดยโมเดลที่ใช่ ในสภาพแวดล้อมที่เหมาะสม และอยู่บนสถาปัตยกรรมที่ถูกต้อง การใช้ agentic AI ได้อย่างประสบความสำเร็จนั้นไม่ได้ขึ้นอยู่กับโมเดลที่ทรงพลังเพียงอย่างเดียว แต่ต้องมีโครงสร้างพื้นฐาน การกำกับดูแล และทักษะ ที่คอยเป็นฐานสนับสนุนอยู่ด้วย ในปี 2026 ความเป็นระบบเปิด ความยืดหยุ่น และความร่วมมือ จะยังคงเป็นหลักการสำคัญที่ช่วยให้องค์กรเปลี่ยนผ่านจากศักยภาพที่เป็นไปได้ ไปสู่ ผลลัพธ์ทางธุรกิจที่วัดผลได้จริง โอเพ่นซอร์สจะยังคงเป็นรากฐานสำคัญที่มอบอิสระและนวัตกรรมที่จำเป็นต่อการสร้างสรรค์สิ่งใหม่ที่จะเกิดขึ้นในอนาคต เพราะไม่มีโมเดลเดียวที่สามารถตอบโจทย์ได้ทุกบริบทของธุรกิจ