Alibaba Cloud Recognized Again as an Emerging Leader in All Four Gartner® Emerging Market Quadrants for Generative AI

Recognition across GenAI infrastructure, models, engineering, and AI apps highlights Alibaba Cloud’s Features and Future Potential capabilities

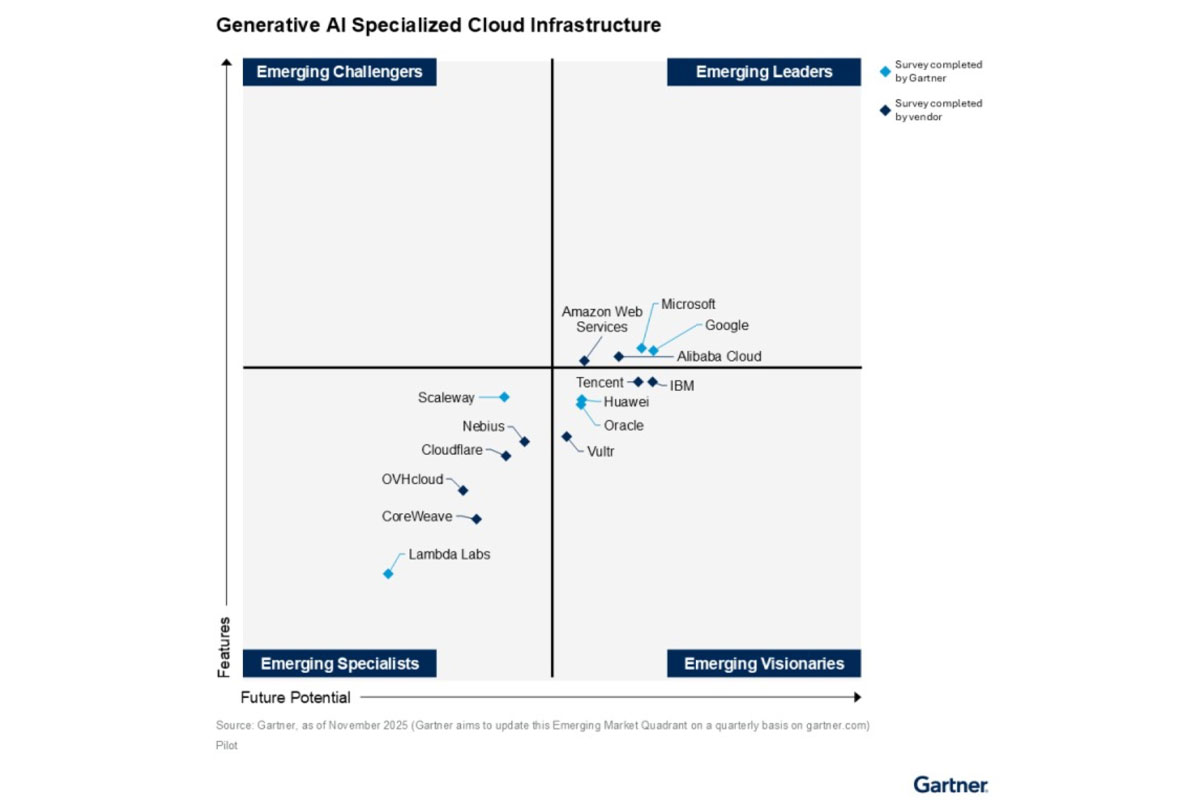

Alibaba Cloud, the digital technology and intelligence backbone of Alibaba Group, today announced it has again been recognized as an Emerging Leader across all four quadrants evaluated in the latest four Gartner® “Innovation Guide for Generative AI” reports, published in November 2025.

According to Gartner, the Emerging Market Quadrant provides “a visualization of generative AI vendors” in a “dynamic and fast-moving market,” and “Emerging Leaders typically possess visibility within the market as well as both strong features and future potential”.

“We believe our recognition as an Emerging Leader across the GenAI stack is a powerful validation of our integrated ‘AI + Cloud’ strategy,” said Jingren Zhou, Chief Technology Officer of Alibaba Cloud Intelligence. “From the optimized infrastructure that powers AI, to our leading Qwen models, the tools to engineer specialized applications, and the productivity apps that deliver value to end-users, we are committed to providing a holistic ecosystem that empowers businesses to innovate and succeed in the fast-moving era of AI.”

The four quadrants covered in the Gartner® “Innovation Guide for Generative AI” reports are: Generative AI Specialized Cloud Infrastructure, Generative AI Model Providers, Generative AI Engineering, and Generative AI Knowledge Management Apps.

A Full-Stack AI Ecosystem

The Gartner reports provide context for the critical capabilities in each domain, all of which Alibaba Cloud believes are addressed by its offerings:

Generative AI Specialized Cloud Infrastructure: Gartner defines this as “offerings that address the need to enable AI and machine learning (ML) activity,” including high-performance compute, storage, and networking for training and inference.

Alibaba Cloud provides a robust, AI-optimized cloud infrastructure foundation to meet these demanding workloads. It is the only cloud service provider in Asia Pacific recognized as an Emerging Leader among four global peers.

Generative AI Model Providers: This market includes “model providers that offer access to commercial or open-source foundation models.”

Alibaba’s proprietary Qwen model series, including the latest Qwen3, is a testament to its strength here. The open-source Qwen models have seen massive community adoption, with over 600 million downloads on platforms like Hugging Face and ModelScope, inspiring the creation of more than 170,000 derivative models.

Model Studio, Alibaba’s AI development platform, embodies this by enabling enterprises to fine-tune, manage, and deploy models efficiently, serving over 1 million corporates and individuals. It enables enterprises to build generative AI applications by leveraging a range of large language models (LLMs), such as Qwen and visual-generation Wan family of models.

Generative AI Engineering: Gartner notes this submarket focuses on “technologies providing full-model life cycle management, specifically adjusted to…developing, refining and deploying generative models.”

Alibaba Cloud’s Platform for AI (PAI), is a comprehensive machine learning and deep learning engineering platform designed for enterprises and developers to build and use AI more easily. It supports the entire AI lifecycle in one integrated platform – from data labelling and model building, to model training, performance optimization, and real-world deployment.